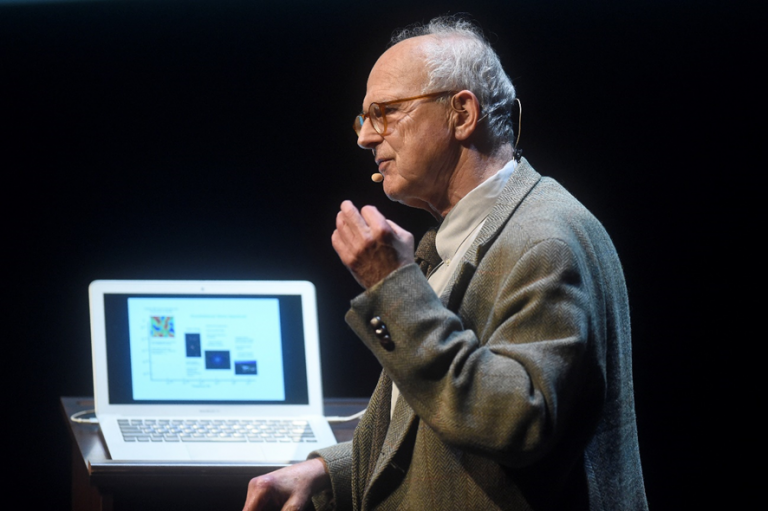

Noah Berger. Word Economic Forum https://www.weforum.org/agenda/2023/02/why-chatgpt-raises-issues-of-trust-ai-science/

• ChatGPT puede parecer simplemente otra fuente de información, pero los medios por los que produce sus resultados plantean dudas sobre la confiabilidad, dice un profesor de ciencias políticas.

• Los modelos de aprendizaje automático parecen sofisticados, pero básicamente son solo máquinas complejas de autocompletar que vuelven a empaquetar el trabajo de otros como si fuera algo nuevo, sin comprender lo que producen.

• Esta es la razón por la que, si bien ChatGPT puede crear un trabajo escrito aparentemente coherente, no es recomendable confundir su producción con conocimiento científico.

De todas las reacciones provocadas por ChatGPT, el chatbot de la empresa estadounidense con fines de lucro OpenAI que produce respuestas gramaticalmente correctas a consultas en lenguaje natural, pocas han igualado las de educadores y académicos.

Los editores académicos se han movido para prohibir que ChatGPT se incluya como coautor y emitan pautas estrictas que describen las condiciones bajo las cuales se puede usar . Las principales universidades y escuelas de todo el mundo, desde la renombrada Sciences Po de Francia hasta muchas universidades australianas , han prohibido su uso.

Estas prohibiciones no son simplemente las acciones de académicos que están preocupados de no poder atrapar a los tramposos. No se trata solo de atrapar a los estudiantes que copiaron una fuente sin atribución. Más bien, la gravedad de estas acciones refleja una pregunta, una que no recibe suficiente atención en la interminable cobertura del chatbot ChatGPT de OpenAI: ¿Por qué deberíamos confiar en todo lo que genera?

Esta es una pregunta de vital importancia, ya que ChatGPT y programas similares se pueden usar fácilmente, con o sin reconocimiento, en las fuentes de información que constituyen la base de nuestra sociedad, especialmente en la academia y los medios de comunicación.

Según mi trabajo sobre la economía política de la gobernanza del conocimiento , las prohibiciones académicas sobre el uso de ChatGPT son una reacción proporcional a la amenaza que plantea ChatGPT para todo nuestro ecosistema de información. Los periodistas y académicos deben tener cuidado al usar ChatGPT.

En función de su salida, ChatGPT puede parecer simplemente otra fuente de información o herramienta. Sin embargo, en realidad, ChatGPT, o más bien el medio por el cual ChatGPT produce su salida, es una daga que apunta directamente a su propia credibilidad como fuentes autorizadas de conocimiento . No debe tomarse a la ligera.

Confianza e información

Piense por qué consideramos que algunas fuentes de información o tipos de conocimiento son más confiables que otros. Desde la Ilustración europea , hemos tendido a equiparar el conocimiento científico con el conocimiento en general.

La ciencia es más que una investigación de laboratorio: es una forma de pensar que prioriza la evidencia con base empírica y la búsqueda de métodos transparentes con respecto a la recopilación y evaluación de evidencia. Y tiende a ser el estándar de oro por el cual se juzga todo el conocimiento.

Por ejemplo, los periodistas tienen credibilidad porque investigan información, citan fuentes y aportan pruebas. Aunque a veces el informe puede contener errores u omisiones, eso no cambia la autoridad de la profesión.

Lo mismo ocurre con los editorialistas de opinión, especialmente los académicos y otros expertos porque ellos (nosotros) obtienen nuestra autoridad de nuestra condición de expertos en un tema. La pericia implica un dominio de las fuentes que se reconocen como parte del conocimiento legítimo en nuestros campos.

La mayoría de los artículos de opinión no tienen muchas citas, pero los académicos responsables podrán señalarle a los pensadores y el trabajo en el que se basan . Y esas fuentes en sí mismas se basan en fuentes verificables que un lector debería poder verificar por sí mismo.

Verdad y salidas

Debido a que los escritores humanos y ChatGPT parecen estar produciendo el mismo resultado (oraciones y párrafos), es comprensible que algunas personas puedan conferir por error esta autoridad de origen científico al resultado de ChatGPT.

Que tanto ChatGPT como los reporteros produzcan oraciones es donde termina la similitud. Lo más importante, la fuente de autoridad, no es lo que producen, sino cómo lo producen.

ChatGPT no produce oraciones de la misma manera que lo hace un reportero. ChatGPT y otros modelos de lenguaje grande de aprendizaje automático pueden parecer sofisticados, pero básicamente son solo máquinas complejas de autocompletar. Solo que en lugar de sugerir la siguiente palabra en un correo electrónico, producen las palabras estadísticamente más probables en paquetes mucho más largos.

Estos programas vuelven a empaquetar el trabajo de otros como si fuera algo nuevo. No “entiende” lo que produce.

La justificación de estas salidas nunca puede ser la verdad. Su verdad es la verdad de la correlación, que la palabra “oración” siempre debe completar la frase “Nos acabamos el uno con el otro…” porque es la ocurrencia más común, no porque exprese algo que se haya observado.

Debido a que la verdad de ChatGPT es solo una verdad estadística, nunca se puede confiar en la salida producida por este programa de la misma manera que podemos confiar en la salida de un reportero o de un académico. No se puede verificar porque se ha construido para crear resultados de una manera diferente a lo que solemos considerar como «científico».

No puede verificar las fuentes de ChatGPT porque la fuente es el hecho estadístico de que la mayoría de las veces, un conjunto de palabras tiende a seguirse.

No importa cuán coherente pueda parecer el resultado de ChatGPT, simplemente publicar lo que produce sigue siendo el equivalente a dejar que el autocompletado se vuelva loco. Es una práctica irresponsable porque pretende que estos trucos estadísticos equivalen a un conocimiento bien fundamentado y verificado.

Del mismo modo, los académicos y otras personas que incorporan ChatGPT en su flujo de trabajo corren el riesgo existencial de echar por tierra todo el edificio del conocimiento científico.

Debido a que la salida de ChatGPT se basa en la correlación, ¿cómo sabe el escritor que es precisa? ¿Lo verificaron con fuentes reales, o el resultado simplemente se ajusta a sus prejuicios personales? Y si son expertos en su campo, ¿por qué usan ChatGPT en primer lugar?

Producción y verificación del conocimiento

El punto es que los procesos de ChatGPT no nos dan forma de verificar su veracidad. Por el contrario, que los reporteros y académicos tengan un método científico y basado en la evidencia para producir conocimiento sirve para validar su trabajo, incluso si los resultados pueden ir en contra de nuestras nociones preconcebidas.

El problema es especialmente agudo para los académicos, dado nuestro papel central en la creación de conocimiento. Confiar en ChatGPT para escribir incluso parte de una columna significa que ya no confían en la autoridad científica incrustada en fuentes verificadas.

En cambio, al recurrir al texto generado estadísticamente, están presentando un argumento de autoridad. Tales acciones también engañan al lector, porque el lector no puede distinguir entre el texto de un autor y una IA.

ChatGPT puede producir conocimiento aparentemente legible, como por arte de magia. Pero haríamos bien en no confundir su producción con conocimiento científico real. Nunca se debe confundir coherencia con comprensión.

ChatGPT promete un fácil acceso a conocimientos nuevos y existentes, pero es un cáliz envenenado. Lectores, académicos y reporteros tengan cuidado.