12 de febrero de 2024

Distinguir entre lo auténtico y lo sintético será un desafío clave en la batalla contra los deepfakes.

Imagen: Getty Images/iStockphoto

Anna María Collard Vicepresidente sénior, estrategia de contenidos , KnowBe4, Inc.

Compartir:

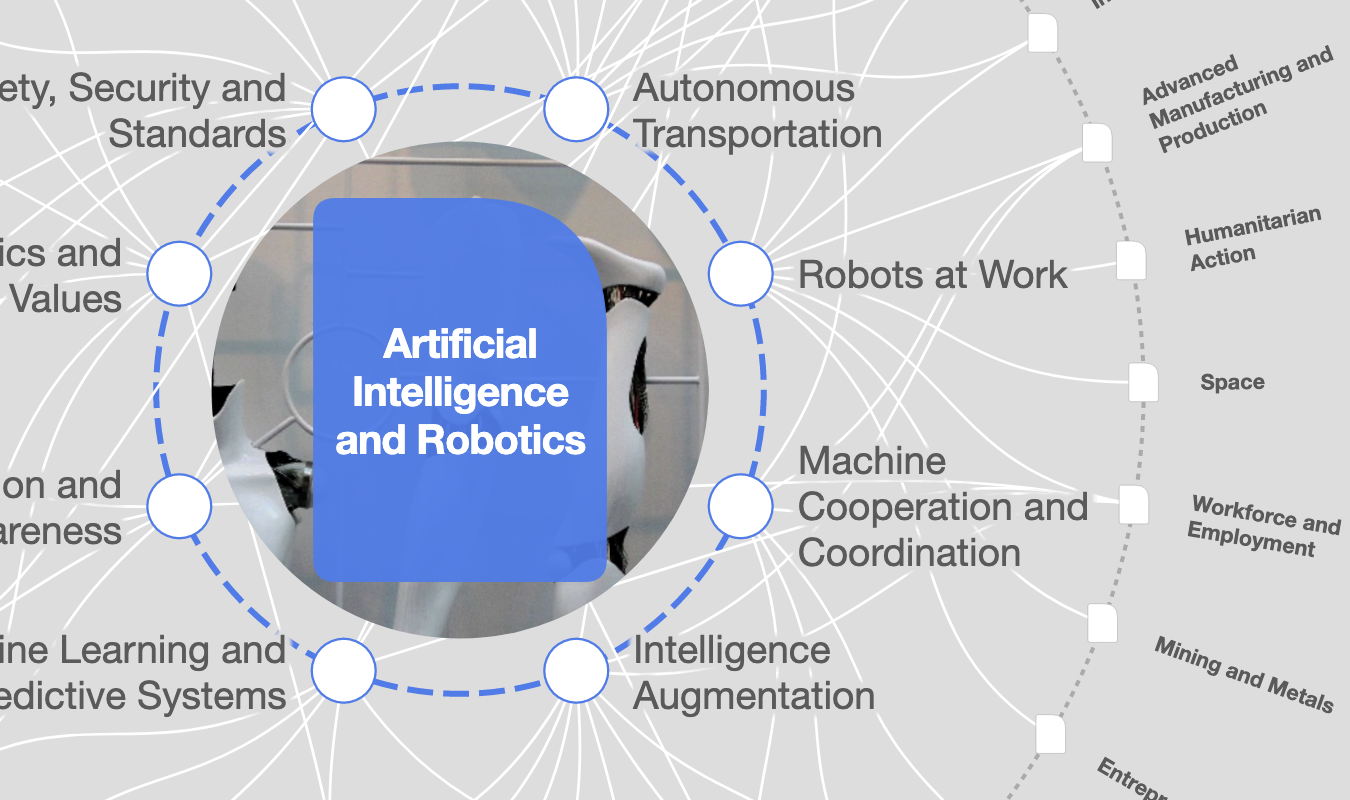

Explore y monitoree cómo la Inteligencia Artificial está afectando las economías, las industrias y los problemas globales.

Inteligencia artificial

Seguir

Este artículo es parte de:Centro para la Cuarta Revolución Industrial

- La desinformación está clasificada como uno de los principales riesgos mundiales para 2024, y los deepfakes son uno de los usos más preocupantes de la IA.

- Los deepfakes utilizados por avatares y chatbots de IA multimodelo en tiempo real y basados en agendas permitirán tipos de manipulación altamente personalizados y efectivos.

- Una mentalidad de confianza cero se convertirá en una herramienta esencial para distinguir entre lo auténtico y lo sintético en entornos en línea cada vez más inmersivos.

Los avances en inteligencia artificial generativa (genAI) y modelos de lenguaje grande (LLM) han llevado a la aparición de deepfakes . El término «deepfake» se basa en el uso de aprendizaje profundo (DL) para recrear versiones nuevas pero falsas de imágenes, vídeos o material de audio existentes. Estos pueden parecer tan realistas que detectarlos como falsos puede ser un gran desafío para los humanos.

Los métodos de manipulación facial son particularmente interesantes porque los rostros son un elemento muy importante de la comunicación humana. Estos medios generados por IA pueden representar de manera convincente a personas reales (y a menudo influyentes) diciendo o haciendo cosas que nunca hicieron, lo que genera contenido engañoso que puede influir profundamente en la opinión pública.

Esta tecnología ofrece grandes beneficios en la industria del entretenimiento, pero cuando se abusa de ella con fines de manipulación política , la capacidad de los deepfakes de fabricar desinformación convincente podría resultar en abstención de votantes, elecciones inestables, polarización social, desacreditación de figuras públicas o incluso incitación a tensiones geopolíticas.

El Foro Económico Mundial ha clasificado la desinformación como uno de los principales riesgos en 2024 . Y los deepfakes han sido clasificados como uno de los usos más preocupantes de la IA .

¿Has leído?

- Las nuevas tecnologías están ayudando a identificar sofisticados deepfakes de IA. Así es cómo

- Cómo detectar un deepfake

- ¿Cómo podemos combatir el preocupante aumento del uso de deepfakes en el ciberdelito?

Con una mayor accesibilidad a las herramientas genAI, los creadores de deepfake de hoy en día no necesitan conocimientos técnicos ni mucho dinero para generar versiones sintéticas hiperrealistas de vídeo, audio o imagen de personas reales. Por ejemplo, el investigador detrás de Countercloud utilizó herramientas de inteligencia artificial ampliamente disponibles para generar un proyecto de investigación de desinformación totalmente automatizado a un costo de menos de $400 por mes, lo que ilustra cuán barato y fácil se ha vuelto crear campañas de desinformación a escala.

El bajo costo, la facilidad y la escala exacerban el problema de la desinformación existente, particularmente cuando se utiliza para la manipulación política y la polarización social. Entre el 8 de diciembre de 2023 y el 8 de enero de 2024, se identificaron en Meta más de 100 anuncios de vídeo deepfake que se hacían pasar por el primer ministro británico Rishi Sunak, muchos de los cuales provocaron respuestas emocionales, por ejemplo, utilizando lenguaje como “la gente está indignada”.

No se puede subestimar el potencial de los deepfakes que impulsan la desinformación para perturbar los procesos democráticos, empañar reputaciones e incitar al malestar público, particularmente dada la creciente integración de los medios digitales en las campañas políticas, la transmisión de noticias y las plataformas de redes sociales.

Los desafíos futuros, como los deepfakes utilizados por chatbots de IA multimodelo en tiempo real y basados en agendas , permitirán tipos de manipulación altamente personalizados y efectivos, lo que exacerbará los riesgos que enfrentamos hoy. La naturaleza descentralizada de Internet, las variaciones en las leyes internacionales de privacidad y la constante evolución de la IA hacen que sea muy difícil, si no imposible, impedir el uso de deepfakes maliciosos.

Contramedidas

1. Tecnología

Hoy en día ya existen múltiples sistemas de detección basados en tecnología. Utilizando aprendizaje automático, redes neuronales y análisis forense, estos sistemas pueden analizar contenido digital en busca de inconsistencias típicamente asociadas con deepfakes. Se pueden utilizar métodos forenses que examinan la manipulación facial para verificar la autenticidad de un contenido. Sin embargo, crear y mantener herramientas de detección automatizadas que realicen análisis en línea y en tiempo real sigue siendo un desafío. Pero, con el tiempo y una amplia adopción, las medidas de detección basadas en IA tendrán un impacto beneficioso en la lucha contra los deepfakes.

2. Esfuerzos políticos

Según Charmaine Ng, miembro del Consejo del Futuro Global sobre Política Tecnológica del WEF: “Necesitamos esfuerzos internacionales y de múltiples partes interesadas que exploren soluciones viables, viables e implementables al problema global de los deepfakes. En Europa , a través de la propuesta Ley de IA, y en Estados Unidos a través de la Orden Ejecutiva sobre IA, los gobiernos están intentando introducir un nivel de responsabilidad y confianza en el sistema de valores de la IA, indicando a otros usuarios la autenticidad o no del contenido.

Exigen que las plataformas en línea detecten y etiqueten el contenido generado por IA, y que los desarrolladores de genAI creen salvaguardas que impidan que actores malintencionados utilicen la tecnología para crear deepfakes. Ya se está trabajando para lograr un consenso internacional sobre una IA responsable y demarcar líneas rojas claras, y debemos aprovechar este impulso”.

Obligar a los proveedores de genAI y LLM a incorporar trazabilidad y marcas de agua en los procesos de creación de deepfake antes de su distribución podría proporcionar un nivel de responsabilidad e indicar si el contenido es sintético o no. Sin embargo, los actores malintencionados pueden evitar esto utilizando versiones liberadas o creando sus propias herramientas no compatibles. Se necesita un consenso internacional sobre estándares éticos, definiciones de uso aceptable y clasificaciones de lo que constituye un deepfake malicioso para crear un frente unificado contra el uso indebido de dicha tecnología.

3. Conciencia pública

La conciencia pública y la alfabetización mediática son contramedidas fundamentales contra los ataques de manipulación e ingeniería social potenciados por la IA. A partir de la educación temprana, las personas deben estar equipadas con las habilidades para identificar el contenido real del inventado, comprender cómo se distribuyen los deepfakes y las tácticas de ingeniería psicológica y social utilizadas por los actores maliciosos. Los programas de alfabetización mediática deben priorizar el pensamiento crítico y equipar a las personas con las herramientas para verificar la información que consumen. Las investigaciones han demostrado que la alfabetización mediática es una habilidad poderosa que tiene el potencial de proteger a la sociedad contra la desinformación impulsada por la IA, al reducir la disposición de una persona a compartir deepfakes .

4. Mentalidad de confianza cero

En ciberseguridad, el enfoque de “confianza cero” significa no confiar en nada de forma predeterminada y, en cambio, verificarlo todo. Cuando se aplica a humanos que consumen información en línea, requiere una buena dosis de escepticismo y verificación constante. Esta mentalidad se alinea con las prácticas de atención plena que alientan a las personas a hacer una pausa antes de reaccionar ante un contenido que les provoca emociones y a interactuar con el contenido digital de manera intencional y reflexiva. Fomentar una cultura de mentalidad de confianza cero a través de programas de atención plena en ciberseguridad (CMP) ayuda a equipar a los usuarios para hacer frente a deepfake y otras ciberamenazas impulsadas por inteligencia artificial que son difíciles de defender solo con tecnología.

A medida que vivimos cada vez más nuestras vidas en línea y con el metaverso inminentemente convirtiéndose en realidad, una mentalidad de confianza cero se vuelve aún más pertinente. En estos entornos inmersivos, será fundamental distinguir entre lo real y lo sintético.

DESCUBRIR

¿Cómo está creando el Foro Económico Mundial barreras para la inteligencia artificial?Mostrar más

No existe una solución milagrosa para mitigar eficazmente la amenaza de los deepfakes en los espacios digitales. Más bien, es necesario un enfoque de múltiples niveles que consista en una combinación de medios tecnológicos y regulatorios, junto con una mayor conciencia pública. Esto requiere una colaboración global entre naciones, organizaciones y la sociedad civil, así como una voluntad política significativa.

Mientras tanto, la mentalidad de confianza cero fomentará una postura proactiva hacia la ciberseguridad, obligando tanto a las personas como a las organizaciones a permanecer siempre alerta frente al engaño digital, a medida que los límites entre los mundos físico y virtual continúan difuminándose.