Jonathan Shriftman octubre 2023 MEDIUM DAIRY DIGEST

Una guía para principiantes sobre la pila de infraestructura de IA generativa

Gracias a Bruno Sanovicz por ayudarme a investigar esto conmigo. Este artículo también contó con aportaciones de fundadores y desarrolladores líderes en el espacio de la IA generativa. Gracias por su tiempo y citas Will Manidis (CEO, Science.io), Harrison Chase (CEO, LangChain), Alex Ratner y Braden Hancock (CEO, COO, Snorkel.ai), Manu Sharma (LabelBox), Will Jennings, Conor Finan (Comunicaciones, director financiero, Gretel.ai), Brannin McBee (fundador, CoreWeave), Krishna Gade y Amit Paka (CEO, director de operaciones, Fiddler.ai), Sid Sheth y PJ Jamkhandi (CEO, director de operaciones, d-Matrix), Pedro Salles Leite (CEO, Innerplay), Faisal Azhar, PhD (líder de IA – Líder de programa y producto LLaMA (por Meta))

Durante casi una década, mi profundo interés en la IA conversacional me ha motivado a explorar su potencial para impulsar la productividad y abordar los desafíos empresariales. Cofundé Humin, un CRM de IA conversacional, que luego fue adquirido por Tinder. Además, dirigí asociaciones tecnológicas en Snaps, una plataforma de inteligencia artificial conversacional de servicio al cliente que fue adquirida por Quiq.

He sido un defensor de las interfaces de IA conversacional y he escrito sobre chatbots , comercio conversacional y el futuro de la búsqueda conversacional . Lo que me entusiasma ahora es el notable progreso de la IA generativa. Ya ha transformado la escritura, la codificación, la creación de contenidos y es muy prometedor en campos como la atención sanitaria, la ciencia y el derecho.

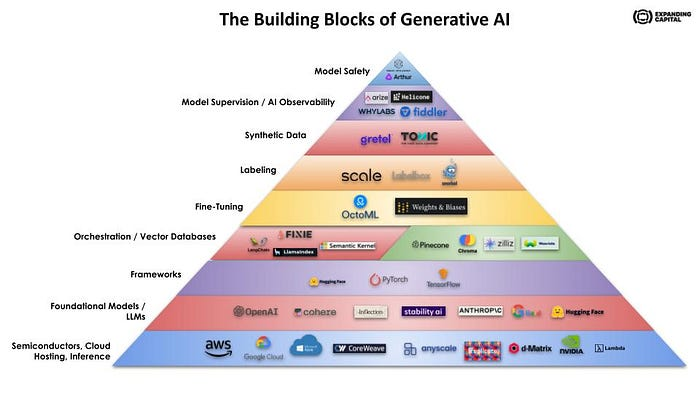

Pero son los componentes fundamentales, los pilares esenciales de las soluciones generativas, los “picos y palas”, los que han evolucionado rápidamente en términos de tecnología e inversión de riesgo. Mantenerse al día con estos avances ha sido un desafío (divertido) en sí mismo.

También me han llamado la atención las recientes adquisiciones en este espacio. Hace apenas dos semanas, Databricks adquirió MosaicML, una plataforma de infraestructura para IA generativa, por la asombrosa cantidad de 1.300 millones de dólares.

En las últimas semanas, dediqué tiempo a comprender el panorama de la infraestructura de IA generativa. En esta publicación, mi objetivo es brindar una descripción clara de los componentes clave, las tendencias emergentes y resaltar a los primeros actores de la industria que impulsan la innovación. Explicaré los modelos fundamentales, la computación, los marcos, la computación, la orquestación y las bases de datos vectoriales, el ajuste, el etiquetado, los datos sintéticos, la observabilidad de la IA y la seguridad del modelo.

Mi objetivo es comprender y explicar estos conceptos de una manera sencilla y directa. Además, espero aprovechar este conocimiento potencialmente para realizar futuras inversiones de crecimiento.

Al final de esta publicación, conectaré todos estos conceptos ilustrando cómo dos empresas utilizan la pila de infraestructura de manera coherente.

Modelos fundamentales y de lenguaje amplio

Comencemos con modelos de lenguaje grandes o LLM. En términos más simples, los LLM son programas informáticos que se capacitan utilizando una extensa colección de texto y código, incluidos libros, artículos, sitios web y fragmentos de código. El objetivo final de los LLM es comprender verdaderamente el significado de las palabras y frases y sobresalir en la generación de nuevas oraciones. Lo hace junto con algo llamado aprendizaje profundo.

Los modelos de base, que es otro nombre para estos LLM, desempeñan un papel vital ya que proporcionan la base para una amplia gama de aplicaciones. En esta investigación, dedicaremos una parte importante de nuestro enfoque a este aspecto fundamental, como sugiere el propio nombre.

Estos modelos aprovechan enormes conjuntos de datos para aprender diversas tareas. Si bien ocasionalmente pueden cometer errores o mostrar sesgos, su capacidad y eficiencia mejoran continuamente.

Para darle vida a este concepto, consideremos un ejemplo práctico. Imagina que eres un escritor en busca de nuevas ideas para una historia. Al ingresar algunas palabras en el modelo, se puede generar una lista de conceptos potenciales. Utilicé esto para recibir sugerencias para el título de este mismo artículo. De manera similar, un científico que enfrenta un problema puede aprovechar el poder de un modelo básico ingresando unas pocas palabras para descubrir la información requerida a partir de una gran cantidad de datos.

Los modelos de fundación han provocado una transformación significativa en el desarrollo de sistemas de inteligencia artificial. Impulsan chatbots y otras interfaces de inteligencia artificial, y su progreso debe mucho al aprendizaje autosupervisado y semisupervisado. Ahora bien, ¿qué significan exactamente estos términos?

En el aprendizaje autosupervisado, un modelo aprende a partir de datos no etiquetados descifrando el significado de las palabras según la frecuencia y el contexto. Por otro lado, el aprendizaje semisupervisado implica entrenar el modelo utilizando una combinación de datos etiquetados y no etiquetados. Los datos etiquetados se refieren a casos en los que ya se ha asignado información específica a los datos, como un conjunto de datos con imágenes etiquetadas de bicicletas y automóviles. Luego, el modelo puede diferenciar entre los dos utilizando las imágenes etiquetadas y refinar aún más su comprensión con las no etiquetadas. En breve profundizaré en el concepto de ajuste.

Ahora, cuando se trata de crear aplicaciones sobre un modelo básico, surge una consideración crucial: ¿debería un desarrollador optar por un modelo cerrado o de código abierto?

Los modelos de IA de código abierto tienen su código y arquitectura subyacentes públicamente accesibles y disponibles gratuitamente para que cualquiera los use, modifique y distribuya. Esta apertura fomenta un entorno colaborativo donde los desarrolladores e investigadores pueden contribuir a la mejora del modelo, adaptarlo a nuevos casos de uso o integrarlo en sus propios proyectos.

Por otro lado, los modelos de IA de código cerrado mantienen su código y arquitectura privados, restringiendo el libre acceso al público. El uso, modificación y distribución de estos modelos están estrictamente controlados, generalmente por la empresa que los desarrolló. Este enfoque tiene como objetivo salvaguardar la propiedad intelectual, mantener el control de calidad y garantizar un uso responsable. Aunque los desarrolladores e investigadores externos no pueden contribuir directamente a las mejoras o adaptaciones del modelo, normalmente pueden interactuar con el modelo a través de interfaces predefinidas o API proporcionadas por la entidad propietaria del modelo.

Elegir entre un modelo abierto y un modelo cerrado puede presentar desafíos. Optar por una solución de código abierto significa asumir la responsabilidad de gestionar los requisitos de infraestructura, como las capacidades de procesamiento, el almacenamiento de datos y la seguridad de la red, que normalmente proporcionan proveedores de modelo cerrado.

Durante el proceso de redacción de este artículo, quise comprender los beneficios y puntos de venta únicos de los modelos. Lo más importante es que busqué opiniones de los constructores en el campo.

Si bien los puntos de vista que encontré pueden haber variado, surgieron algunos temas clave al seleccionar un modelo base: la precisión deseada de la aplicación, la disposición del equipo de desarrolladores para manejar su propia infraestructura y la inclinación a seguir con lo familiar, aunque suficiente exploración. No se ha realizado.

En primer lugar, la precisión es crucial. Dependiendo de la tarea que el modelo deba realizar, la tolerancia a los errores puede diferir. Por ejemplo, un chatbot de ventas puede manejar errores ocasionales, lo que lo hace adecuado para construir sobre un modelo base existente. Sin embargo, consideremos el caso de un vehículo autónomo, donde los errores podrían tener consecuencias catastróficas.

En segundo lugar, el alojamiento en la nube juega un papel importante. Para las startups ágiles que buscan mantener operaciones eficientes, lidiar con la potencia informática, el almacenamiento de datos y las complejidades técnicas puede desviar su atención de sus objetivos principales. Es por eso que muchas empresas emergentes optan por construir sobre una plataforma de código cerrado ya preparada como Chat-GPT. Por otro lado, las grandes corporaciones equipadas con experiencia interna en gestión de infraestructura pueden inclinarse hacia la ruta del código abierto para mantener el control sobre todos los aspectos y obtener una comprensión más profunda de los resultados del sistema.

Finalmente, los objetivos comerciales ejercen su influencia. Diferentes empresas tienen agendas diferentes, lo que puede influir en el proceso de toma de decisiones. Zoom, por ejemplo, invirtió y utiliza Anthropic, un modelo diseñado para casos de uso y seguridad empresariales. Si bien es posible que Anthropic no posea un sistema superior en comparación con OpenAI, es probable que Zoom quiera evitar el riesgo de que OpenAI/Microsoft, que compite con Teams, utilice sus datos. Estas consideraciones estratégicas juegan un papel importante a la hora de determinar qué socios eligen las empresas para construir sus sistemas.

El panorama de los modelos de lenguajes grandes (LLM) continúa expandiéndose. A continuación se muestran algunos modelos líderes como GPT4 y DALL-E de OpenAI, Cohere, Claude de Anthropic, LLaMA de Meta AI, StabilityAI, MosaicML e Inflection AI.

OpenAI, piedra angular de la industria de la IA, es reconocida por sus avances en GPT4 y DALL-E. ChatGPT, un modelo de código cerrado con una impresionante interfaz de IA conversacional, permite a los bots mantener conversaciones sofisticadas con personas, mientras que DALL-E puede generar imágenes únicas a partir de descripciones textuales.

MosaicML, una startup de IA de código abierto, ha desarrollado una plataforma para entrenar modelos de lenguaje grandes e implementar herramientas de IA generativa. Recientemente adquirido por Databricks, el enfoque único de código abierto de MosaicML seguirá capacitando a las organizaciones para crear sus propios modelos de lenguaje.

La contribución de Meta AI al campo de la IA, LLaMA, es un modelo de código abierto. Al animar a otros investigadores a utilizar LLaMA, Facebook pretende fomentar el desarrollo de nuevas aplicaciones y mejorar la precisión de los modelos lingüísticos.

StabilityAI, reconocida por sistemas como Dance Diffusion y Stable Diffusion, es líder en sistemas de generación de imágenes y música de código abierto. Su objetivo es inspirar la creatividad global. La empresa también cuenta con MedARC, un modelo fundamental para las contribuciones de la IA médica.

Anthropic, una empresa de código cerrado cofundada por veteranos de OpenAI, creó Claude, un modelo de lenguaje seguro y capaz. Claude se destaca como un nuevo modelo para el manejo de datos, estableciendo un punto de referencia temprano para la IA responsable.

Inflection, la startup del modelo fundamental de IA bien financiada con una visión audaz de hacer «IA personal para todos», recientemente su poderoso modelo de lenguaje impulsa el agente conversacional Pi. La empresa cuenta con el respaldo de Microsoft, Reid Hoffman, Bill Gates, Eric Schmidt y Nvidia.

Finalmente, Cohere, una startup canadiense, ofrece un modelo de lenguaje grande confiable y escalable diseñado para uso empresarial. Su modelo satisface los requisitos específicos de las empresas, garantizando confiabilidad y escalabilidad.

Semiconductores, chips, alojamiento en la nube, inferencia, implementación

Los modelos de IA generativa se basan en potentes recursos computacionales para entrenar y generar resultados.

Si bien comencé con modelos fundamentales, las GPU y TPU (chips especializados), junto con el alojamiento en la nube, realmente forman la base de la infraestructura de IA generativa.

La computación, que es la capacidad de procesar datos (y realizar cálculos), desempeña un papel fundamental en los sistemas de IA. Las GPU, CPU y TPU son diferentes tipos de computación. Lo que importa en la pila de IA generativa son las GPU, que fueron diseñadas originalmente para tareas gráficas pero sobresalen en operaciones computacionalmente intensivas, como redes de entrenamiento para IA generativa. Las GPU están optimizadas para el procesamiento informático en paralelo, lo que significa dividir una tarea grande en tareas más pequeñas que pueden ser procesadas simultáneamente por varios procesadores. Las tareas de IA/ML son una carga de trabajo altamente paralelizable, por eso las GPU han tenido sentido.

La IA generativa requiere importantes recursos computacionales y grandes conjuntos de datos, que se procesan y almacenan en centros de datos de alto rendimiento. Las plataformas en la nube como AWS, Microsoft Azure y Google Cloud proporcionan recursos escalables y GPU para entrenar e implementar modelos generativos de IA.

Nvidia, líder en GPU, superó recientemente una capitalización de mercado de 1 billón de dólares, y nuevos participantes como d-Matrix están ingresando al sector con chips de alto rendimiento para IA generativa para ayudar con la inferencia, que es el proceso de utilizar un modelo generativo entrenado para hacer predicciones sobre nuevos datos. d-Matrix está construyendo un nuevo chip para inferencia, utilizando la técnica de computación digital en memoria (DIMC) para reducir significativamente la latencia por token en comparación con los aceleradores de computación actuales. d-Matrix cree que resolver el problema de la integración de la memoria y la computación es la clave para mejorar la eficiencia de la computación de la IA para manejar la explosión de las aplicaciones de inferencia de una manera potente y rentable.

Lambda Labs ayuda a las empresas a implementar modelos de IA bajo demanda. Lambda proporciona estaciones de trabajo, servidores, portátiles y servicios en la nube a ingenieros energéticos. Más recientemente, Lambda lanzó GPU Cloud, un servicio en la nube de GPU dedicado para el aprendizaje profundo.

CoreWeave es un proveedor de servicios en la nube especializado que se centra en cargas de trabajo altamente paralelizables a escala. La empresa ha obtenido financiación de Nvidia y del fundador de GitHub. Entre sus clientes se incluyen empresas de IA generativa como Stability AI y admite proyectos de aprendizaje automático y IA de código abierto.

Además, existen empresas especializadas dedicadas a dar soporte a la IA Generativa. HuggingFace, que es esencialmente GitHub para LLM, ofrece un recurso informático de inteligencia artificial integral con una plataforma de colaboración llamada Hub, que facilita el intercambio y la implementación de modelos en las principales plataformas de nube.

Lo interesante es que los proveedores de la nube se están alineando con actores clave del modelo fundamental; Microsoft invirtió recursos y un capital significativo en OpenAI, Google invirtió en Anthropic y complementa sus iniciativas de Google Brain, y Amazon se alineó con HuggingFace. La conclusión es que el dominio anterior de AWS basado en créditos e innovación ya no es la opción predeterminada para las empresas que quieran utilizar uno de los modelos fundamentales específicos.

Capa de orquestación/marcos de aplicación

El siguiente nivel son los marcos de aplicaciones que facilitan la integración perfecta de modelos de IA con diferentes fuentes de datos, lo que permite a los desarrolladores lanzar aplicaciones rápidamente.

La conclusión clave de los marcos de aplicaciones es que aceleran la creación de prototipos y el uso de modelos de IA generativa.

La empresa más notable aquí es LangChain, que originalmente comenzó como un proyecto de código abierto y luego evolucionó hasta convertirse en una startup adecuada. Su introducción de un marco de código abierto, diseñado específicamente para optimizar el desarrollo de aplicaciones utilizando LLM. El concepto central de este marco gira en torno a la noción de «encadenar» varios componentes para crear chatbots, respuesta generativa a preguntas (GQA) y resumen.

Me conecté con Harrison Chase, el fundador y director ejecutivo. Dijo que “LangChain ofrece dos grandes valores agregados. La primera es una colección de abstracciones, cada una de las cuales representa un módulo diferente que es necesario para crear aplicaciones LLM complejas. Estos módulos proporcionan una interfaz estándar para todas las integraciones/implementaciones dentro de ese módulo, lo que facilita el cambio de proveedor con una sola línea de código. Esto ayuda al equipo a experimentar rápidamente con diferentes proveedores de modelos (OpenAI vs Anthropic), vectores (Pinecone vs Chroma), modelos de incrustación (OpenAI vs Cohere) y muchos otros. El segundo gran valor agregado está en las cadenas: formas comunes de realizar secuencias más complejas de llamadas de LLM para habilitar RAG, resumen, etc.

Otro jugador es Fixie AI, fundado por ex jefes de ingeniería de Apple y Google. Fixie AI tiene como objetivo establecer conexiones entre modelos de generación de texto como ChatGPT de OpenAI y datos, sistemas y flujos de trabajo a nivel empresarial. Por ejemplo, las empresas pueden aprovechar Fixie AI para incorporar capacidades de modelo de lenguaje en sus flujos de trabajo de atención al cliente, donde los agentes pueden procesar tickets de clientes, recuperar automáticamente información de compra relevante, emitir reembolsos si es necesario y generar borradores de respuestas a los tickets.

Bases de datos vectoriales

El siguiente nivel en la pila es la base de datos vectorial, que es un tipo de base de datos especializada que almacena datos de una manera que facilita la búsqueda de datos similares. Lo logra representando cada dato como una lista de números, conocida como vector.

Estos números en el vector corresponden a las características o atributos de los datos. Por ejemplo, si trabajamos con imágenes, los números en el vector pueden representar los colores, las formas y el brillo de la imagen. Dentro de las bases de datos vectoriales, un término importante a comprender es el de incrustaciones. Las incrustaciones son un tipo de representación de datos que encapsula información semántica crucial para que la IA adquiera comprensión y mantenga una memoria a largo plazo, lo que resulta vital para ejecutar tareas complejas.Las incrustaciones son un tipo de representación de datos que encapsula información semántica crucial para que la IA adquiera comprensión y mantenga una memoria a largo plazo, lo que resulta vital para ejecutar tareas complejas.

He aquí un ejemplo específico. Una imagen de una bicicleta se puede convertir de manera eficiente en una serie de valores numéricos, que abarcan características como el tamaño, el color de la rueda, el color del cuadro y el color del manillar. Estas representaciones numéricas facilitan el almacenamiento y el análisis sin problemas, lo que presenta una ventaja sobre solo una imagen. La conclusión es que las bases de datos vectoriales poseen la capacidad de procesar y almacenar datos de una manera fácilmente comprensible para las máquinas.

Estas bases de datos se pueden conceptualizar como tablas con infinitas columnas.

A lo largo de mis experiencias anteriores desarrollando IA conversacional, he trabajado principalmente con bases de datos relacionales que almacenan datos en tablas. Sin embargo, las bases de datos vectoriales destacan por representar el significado semántico de los datos, lo que permite tareas como búsqueda de similitudes, recomendación y clasificación.

Varias empresas han desarrollado bases de datos vectoriales e incrustaciones.

Pinecone es el creador de la categoría. Tienen una base de datos vectorial distribuida diseñada para aplicaciones de aprendizaje automático a gran escala. Además de las empresas de IA generativa, cuenta con clientes como Shopify, Gong, Zapier y Hubspot, que brindan una solución de nivel empresarial con certificación SOC 2 Tipo II y preparación para GDPR. El cumplimiento del RGPD es importante porque si un desarrollador tiene que eliminar un registro, no es tan difícil hacerlo en una base de datos, pero es mucho más difícil eliminar datos incorrectos de un modelo debido a la forma en que está estructurado. Pinecone también ayuda a conversar experiencias con la memoria.

Otra base de datos vectorial notable es Chroma, que es una nueva solución de código abierto centrada en la búsqueda de similitudes de alto rendimiento. Chroma permite a los desarrolladores agregar estado y memoria a sus aplicaciones habilitadas para IA. Muchos desarrolladores han expresado su deseo de contar con una herramienta de inteligencia artificial como “ChatGPT pero para sus datos”, y Chroma sirve como puente al permitir la recuperación de documentos basada en incrustaciones. Desde su lanzamiento, Chroma ha ganado terreno con más de 35.000 descargas de Python. Además, ser de código abierto se alinea con el objetivo de hacer que la IA sea más segura y esté más alineada.

Weaviate es una base de datos vectorial de código abierto ideal para empresas que buscan flexibilidad. Es compatible con otros modelos de hubs como OpenAI o HuggingFace.

Sintonia FINA

El siguiente nivel en la infraestructura es el ajuste. El ajuste, en el ámbito de la IA generativa, implica entrenar más un modelo en una tarea o conjunto de datos específicos. Este proceso mejora el rendimiento del modelo y lo adapta para cumplir con los requisitos únicos de esa tarea o conjunto de datos. Es como cómo un deportista polivalente se centra en deportes específicos para destacar en él; una IA de base amplia también puede concentrar su conocimiento en tareas específicas mediante ajustes.

Los desarrolladores crean una nueva aplicación sobre un modelo preexistente. Si bien los modelos de lenguaje entrenados en conjuntos de datos masivos pueden producir textos gramaticalmente correctos y fluidos, pueden carecer de precisión en ciertas áreas como la medicina o el derecho. Ajustar el modelo en conjuntos de datos de dominios específicos le permite internalizar las características únicas de esas áreas, mejorando su capacidad para generar texto relevante.

Esto se alinea con el punto anterior sobre los modelos básicos que sirven como plataformas para otros servicios y productos. La capacidad de ajustar estos modelos es un factor clave en su adaptabilidad. En lugar de empezar desde cero, lo que requiere una potencia computacional sustancial y una gran cantidad de datos, ajustar un modelo existente agiliza el proceso y es rentable, especialmente si ya se cuentan con conjuntos de datos grandes y específicos.

Una empresa destacada en este campo es Weights and Bias.

Etiquetado

El etiquetado preciso de los datos es crucial para el éxito de los modelos de IA generativa.

Los datos pueden adoptar diversas formas, incluidas imágenes, texto o audio. Las etiquetas sirven como descripciones de los datos. Por ejemplo, una imagen de una bicicleta puede etiquetarse como “bicicleta” o “bicicleta”. Uno de los aspectos más tediosos del aprendizaje automático es proporcionar un conjunto de etiquetas para enseñar al modelo de aprendizaje automático lo que necesita saber.

El etiquetado de datos juega un papel importante en el aprendizaje automático, ya que los algoritmos aprenden de los datos. La precisión de las etiquetas afecta directamente las capacidades de aprendizaje del algoritmo. Cada startup de IA o laboratorio de I+D corporativo enfrenta el desafío de anotar datos de entrenamiento para enseñar a los algoritmos qué identificar. Ya sean médicos que evalúan el tamaño del cáncer a partir de escáneres o conductores que marcan las señales de tráfico en imágenes de vehículos autónomos, el etiquetado es un paso necesario.

Los datos inexactos conducen a resultados inexactos de los modelos.

El etiquetado de datos sigue siendo un desafío y un obstáculo importante para el avance del aprendizaje automático y la inteligencia artificial en muchas industrias. Es costoso, requiere mucha mano de obra y es un desafío para los expertos en la materia asignar tiempo para ello, lo que lleva a algunos a recurrir a plataformas de crowdsourcing cuando las limitaciones de privacidad y experiencia son mínimas. A menudo se trata como trabajo de “limpieza”, aunque los datos son los que en última instancia controlan el comportamiento y la calidad del modelo. En un mundo donde la mayoría de las arquitecturas de modelos son de código abierto, los datos privados y relevantes para el dominio son una de las formas más poderosas de construir un foso de IA.

Una empresa que está acelerando el proceso de etiquetado es Snorkel AI. La tecnología de la empresa comenzó como una iniciativa de investigación en el Laboratorio de IA de Stanford para superar el cuello de botella del etiquetado en la IA. La plataforma de Snorkel ayuda a los expertos en la materia a etiquetar datos mediante programación (mediante una técnica conocida como «supervisión débil») en lugar de manualmente (uno por uno), manteniendo a los humanos informados y mejorando significativamente la eficiencia del etiquetado. Esto puede disminuir el proceso de meses a horas o días, dependiendo de la complejidad de los datos, y hace que los modelos sean más fáciles de mantener a largo plazo, ya que las etiquetas de entrenamiento pueden revisarse y actualizarse fácilmente a medida que los datos cambian, se descubren nuevos modos de error o se actualizan las operaciones comerciales. los objetivos cambian.

«Detrás de cada operación centrada en el modelo, como el entrenamiento previo y el ajuste, están las operaciones centradas en datos aún más importantes que crean los datos de los que el modelo realmente aprende», dice Alex Ratner, cofundador y director ejecutivo de Snorkel AI. «Nuestro objetivo es hacer que el desarrollo de IA centrado en datos se parezca menos a un trabajo manual y ad hoc y más a un desarrollo de software para que cada organización pueda desarrollar y mantener modelos que funcionen con datos y casos de uso específicos de su empresa». La plataforma centrada en datos de Snorkel también ayuda a identificar sistemáticamente errores del modelo para que los esfuerzos de etiquetado puedan centrarse en las porciones de datos donde tendrán mayor impacto. En la actualidad, lo utilizan empresas Fortune 500 en industrias con uso intensivo de datos, como finanzas, comercio electrónico, seguros, telecomunicaciones y medicina.

Labelbox es una empresa líder en etiquetado de IA. Hablé con Manu Sharma, director ejecutivo. Labelbox ayuda a empresas como OpenAI, Walmart, Stryker y Google a etiquetar datos y gestionar el proceso. «Labelbox hace que los modelos fundamentales sean útiles en un contexto empresarial». Los desarrolladores utilizan el etiquetado asistido por modelos de Labelbox para convertir rápidamente las predicciones del modelo en nuevos datos de entrenamiento etiquetados automáticamente para casos de uso de IA generativa.

Otras empresas se han especializado en interfaces y fuerzas de trabajo para realizar anotaciones manuales. Uno de ellos es Scale, que se centra en agencias y empresas gubernamentales. La empresa ofrece una plataforma de etiquetado de datos visuales que combina software y experiencia humana para etiquetar datos de imágenes, texto, voz y video para empresas que desarrollan algoritmos de aprendizaje automático. Scale emplea a decenas de miles de contratistas para el etiquetado de datos. Inicialmente suministraron datos etiquetados a empresas de vehículos autónomos y ampliaron su base de clientes al gobierno, el comercio electrónico, la automatización empresarial y la robótica. Los clientes incluyen Airbnb, OpenAI, DoorDash y Pinterest.

Datos sintéticos

Los datos sintéticos, también conocidos como datos creados artificialmente que imitan datos reales, ofrecen varios beneficios y aplicaciones en el ámbito del aprendizaje automático y la inteligencia artificial (IA). Entonces, ¿por qué considerarías utilizar datos sintéticos?

Un caso de uso principal de los datos sintéticos surge cuando los datos reales no están disponibles o no se pueden utilizar. Al generar conjuntos de datos artificiales que poseen las mismas características que los datos reales, puede desarrollar y probar modelos de IA sin comprometer la privacidad ni encontrar limitaciones de datos.

Hay muchas ventajas de utilizar datos sintéticos.

Los datos sintéticos protegen la privacidad, ya que carecen de información de identificación personal (PII) y de los riesgos de HIPAA. Se garantiza el cumplimiento de las normativas sobre datos, como el RGPD, mientras se utilizan los datos de forma eficaz. Permite aplicaciones escalables de aprendizaje automático e inteligencia artificial mediante la generación de datos para capacitación e implementación. Los datos sintéticos mejoran la diversidad, minimizan los sesgos al representar diversas poblaciones y escenarios y promueven la equidad y la inclusión en los modelos de IA. Las técnicas de generación de datos condicionales y los datos sintéticos también abordan el problema del «arranque en frío» para las empresas emergentes que no tienen suficientes datos para probar y entrenar modelos. Las empresas necesitarán sintetizar conjuntos de datos patentados que luego se aumentarán utilizando técnicas de generación de datos condicionales para completar los casos extremos que no pueden recopilar en la naturaleza; A esto a veces se le llama la “última milla” del entrenamiento modelo.

Cuando se trata de soluciones de datos sintéticos, varias empresas ofrecen opciones confiables. Gretel.ai, Tonic.ai y Mostly.ai son ejemplos dignos de mención en este espacio.

Gretel.ai permite a los ingenieros generar conjuntos de datos artificiales basados en sus conjuntos de datos reales. Gretel combina modelos generativos, tecnologías que mejoran la privacidad y métricas de datos e informes para permitir a los desarrolladores e ingenieros empresariales crear datos sintéticos de dominios específicos bajo demanda que sean precisos y seguros. Los tres fundadores tienen experiencia en ciberseguridad y han trabajado en diversos roles en la comunidad de inteligencia de EE. UU. y su CTO era un oficial alistado en la Fuerza Aérea.

Tonic.ai, por ejemplo, promueve sus datos como “datos falsos reales”, enfatizando la necesidad de que los datos sintéticos respeten y protejan la privacidad de los datos reales. Su solución encuentra aplicaciones en pruebas de software, capacitación de modelos de aprendizaje automático, análisis de datos y demostraciones de ventas.

Supervisión de modelos/observabilidad de IA

El siguiente nivel de la pila es la observabilidad de la IA, que consiste en monitorear, comprender y explicar el comportamiento de los modelos de IA. En pocas palabras, garantiza que los modelos de IA funcionen correctamente y tomen decisiones imparciales y no dañinas.

La supervisión del modelo, que es un subconjunto de la observabilidad de la IA, se centra específicamente en garantizar que los modelos de IA se alineen con su propósito previsto. Implica verificar que los modelos no estén tomando decisiones que puedan ser perjudiciales o poco éticas.

La deriva de datos es otro concepto importante a considerar. Se refiere a cambios en la distribución de datos a lo largo del tiempo, que pueden hacer que los modelos de IA se vuelvan menos precisos. Si estos cambios favorecen a ciertos grupos, el modelo puede volverse más sesgado y conducir a decisiones injustas. A medida que cambia la distribución de los datos, la precisión del modelo disminuye, lo que puede dar lugar a predicciones y decisiones incorrectas. Las plataformas de observabilidad de IA brindan soluciones para abordar estos desafíos.

Para arrojar luz sobre la necesidad de que la IA sea observable, me conecté con Krishna Gade y Amit Paka, director ejecutivo y director de operaciones de Fiddler.ai. Gade, que anteriormente trabajó como líder de ingeniería en Facebook News Feed, fue testigo de primera mano de los desafíos que enfrentan las empresas para comprender sus propios modelos de aprendizaje automático.

“A medida que esos sistemas se volvieron más maduros y complejos, fue extremadamente difícil comprender cómo funcionaban. Preguntas como ‘¿Por qué veo esta historia en mi feed? ¿Por qué esta noticia se está volviendo viral? ¿Esta noticia es real o falsa? Fueron difíciles de responder”. Gade y su equipo desarrollaron una plataforma en Fiddler para abordar estas preguntas, aumentar la transparencia en los modelos de Facebook y resolver el problema de la «caja negra de la IA». Ahora, Krishna y Amit Paka lanzaron la plataforma Fiddler para ayudar a empresas como Thumbtack e incluso In-Q-Tel (el fondo de riesgo de la CIA) con explicabilidad de modelos, monitoreo moderno y detección de sesgos, brindando a las empresas una forma centralizada de administrar esta información y construir la próxima generación de IA. Amit compartió conmigo: “La observabilidad de la IA se ha vuelto muy importante para una implementación segura y responsable de la IA. Ahora es imprescindible para todas las empresas que introducen productos de IA. No creemos que podamos adoptar la IA empresarial sin la observabilidad de la IA, que está formando la tercera capa crítica en la pila de IA. “

Arize y WhyLabs son otras empresas que han creado sólidas soluciones de observabilidad para LLM en producción. Estas plataformas abordan la adición de barreras de seguridad para garantizar indicaciones y respuestas adecuadas para las aplicaciones LLM en tiempo real. Estas herramientas identifican y mitigan mensajes maliciosos, datos confidenciales, respuestas tóxicas, temas problemáticos, alucinaciones e intentos de jailbreak en cualquier modelo LLM.

Aporia es otra empresa que enfatiza la importancia de una plataforma de observabilidad de IA, reconociendo que la confianza se puede perder en segundos y tardar meses en recuperarse. Con un enfoque en el valor de vida del cliente/precios dinámicos, Aporia ahora está profundizando en la IA generativa con su funcionalidad de observabilidad LLM.

Seguridad del modelo

En la parte superior de la pila está la seguridad del modelo. Un riesgo importante de la IA generativa son los resultados sesgados. Los modelos de IA tienden a adoptar y propagar sesgos presentes en los datos de entrenamiento. Por ejemplo, una herramienta de selección de currículums de IA favoreció a los candidatos con el nombre «Jared» y experiencia en lacrosse en la escuela secundaria, lo que reveló sesgos en el conjunto de datos. Amazon enfrentó un desafío similar cuando su herramienta de selección de currículums mediante IA mostró un sesgo intrínseco hacia los candidatos masculinos debido a que los datos de capacitación consistían predominantemente en empleados varones.

Otra preocupación es el uso malicioso de la IA. Los deepfakes, que implican la difusión de información falsa a través de imágenes, vídeos o textos creíbles pero inventados, podrían convertirse en un problema. Un incidente reciente involucró una imagen generada por IA que representaba una explosión en el Pentágono, causando miedo y confusión entre el público. Esto pone de relieve el potencial de que la IA se utilice como arma para generar información errónea y la necesidad de salvaguardias para evitar ese uso indebido.

Además, pueden surgir consecuencias no deseadas a medida que los sistemas de IA crecen en complejidad y autonomía. Estos sistemas pueden exhibir comportamientos que los desarrolladores no anticiparon, lo que plantea riesgos o conduce a resultados no deseados. Por ejemplo, los chatbots desarrollados por Facebook comenzaron a inventar su propio lenguaje para comunicarse de manera más eficiente, un resultado inesperado que enfatizó la necesidad de un monitoreo riguroso y precauciones de seguridad.

Para mitigar estos riesgos, técnicas como la detección y mitigación de sesgos son cruciales. Esto implica identificar sesgos en la salida del modelo e implementar medidas para minimizarlos, como mejorar la diversidad de datos de entrenamiento y aplicar técnicas de equidad. Los mecanismos de retroalimentación de los usuarios, donde los usuarios pueden señalar resultados problemáticos, desempeñan un papel vital en el perfeccionamiento de los modelos de IA. Las pruebas y la validación adversas desafían a los sistemas de IA con entradas difíciles para descubrir debilidades y puntos ciegos.

Robust Intelligence ayuda a las empresas a realizar pruebas de estrés de sus modelos de IA para evitar fallas. La oferta principal de Robust Intelligence es un firewall de IA que protege los modelos de IA de la empresa de errores mediante pruebas de estrés continuas. Curiosamente, este firewall de IA es un modelo de IA en sí mismo, cuya tarea es predecir si un punto de datos podría dar como resultado un pronóstico incorrecto.

Arthur AI debutó en 2019 con el objetivo principal de ayudar a las empresas a monitorear sus modelos de aprendizaje automático mediante la entrega de un firewall para LLM similar a la solución de Robust Intelligence. Esta solución monitorea y mejora la precisión y explicabilidad del modelo.

CredoAI guía a las empresas a través de las ramificaciones éticas de la IA. Su atención se centra en la gobernanza de la IA, lo que permite a las empresas medir, monitorear y gestionar los riesgos generados por la IA a gran escala.

Finalmente, Skyflow proporciona un servicio basado en API para almacenar de forma segura información confidencial y de identificación personal. Los enfoques de Skyflow atienden a diversos sectores, como fintech y atención médica, y ayudan a almacenar de forma segura información crítica, como detalles de tarjetas de crédito.

¿Cómo encaja todo esto?

Para obtener una comprensión más profunda de una empresa líder que utiliza estas herramientas, hablé con Will Manidis, director ejecutivo de Science. yo. ScienceIO está revolucionando la industria de la salud mediante la creación de modelos básicos de última generación creados exclusivamente para la atención médica. Cientos de las organizaciones de atención médica más importantes utilizan modelos ScienceIO en el centro de sus flujos de trabajo, lo que le brinda a Will una visión única de cómo se implementan los LLM en producción. Esto es lo que está viendo:

- Computación: ScienceIO confía en Lambda Labs para sus necesidades informáticas, utilizando un clúster local. Esto garantiza capacidades de procesamiento eficientes y escalables, de una manera más rentable que un hiperescalador como AWS o GCP.

- Modelo fundamental: ScienceIO aprovecha sus datos internos para crear su propio modelo fundamental. El núcleo de su negocio es una API que facilita la transformación en tiempo real de datos sanitarios no estructurados en datos estructurados (resolución de entidades nombradas y vinculación), que luego se pueden utilizar con fines de búsqueda y análisis. Muchos de sus clientes optaron por encadenar ScienceIO junto con un modelo de propósito más general en sus flujos de trabajo para tareas como la recuperación y síntesis de información.

- Vector: Una de las ofertas principales de ScienceIO es su producto de integración, creado para integraciones de alta calidad para el ámbito de la atención sanitaria. Una de las creencias fundamentales de Will es que las incrustaciones personalizadas serán cada vez más importantes, particularmente como complemento de los modelos de propósito general. ScienceIO utiliza Chroma ampliamente para almacenar y consultar estas incrustaciones de vectores.

- Orquestación: para el desarrollo de aplicaciones, ScienceIO confía en LangChain. El almacenamiento interno, el control de versiones y el acceso a los modelos están impulsados por Huggingface.

- Ajuste fino: si bien los modelos básicos básicos de ScienceIO están entrenados de novo exclusivamente en datos de atención médica, es decir, nunca han visto montones de datos basura de redes sociales o similares, muchos clientes están interesados en ajustes adicionales para sus caso de uso. ScienceIO lanzó Learn & Annotate, sus soluciones de ajuste y participación humana para abordar estos casos de uso.

También hablé con Pedro Salles Leite, director ejecutivo de Innerplay, que utiliza IA para ayudar a personas y empresas a ser más creativas. Innerplay ayuda a las empresas a crear vídeos de forma más rápida, incluida la escritura de guiones.

Pedro lleva ocho años estudiando y construyendo casos de uso de IA. Con respecto a su pila de infraestructura, dijo que su trabajo es asegurarse de que el producto tenga sentido para el usuario… no establecer una orquestación o modelos fundamentales, sino simplemente agregar otra complejidad. Aquí está su pila:

- Modelos básicos: Innerplay utiliza 14 modelos básicos diferentes para dar vida a las ideas. Utilizan modelos cerrados principalmente porque “no hay GPU hasta que el mercado de productos se ajuste”.

- Bases de datos vectoriales: Innerplay utiliza bases de datos vectoriales para tareas como el procesamiento de documentos PDF. Generan un script a partir de PDF y se necesitan bases de datos vectoriales para lograrlo.

- Ajustes: Innerplay cree firmemente en los ajustes. La empresa prepara manualmente conjuntos de datos, pero planea utilizar IA para preparar los datos y realizar ajustes en el futuro.

- Creación de prototipos: lo utilizan para evaluar resultados y comparar modelos. Spellbook by Scale se utiliza a menudo para probar rápidamente iteraciones en el proceso de aprendizaje automático antes de pasar a Python/producción.

- Observabilidad de la IA: ahora están empezando a pensar en la observabilidad de la IA para mejorarla de manera consciente de la privacidad. Ser una plataforma de creación de contenidos. Pedro dijo: «Innerplay necesita asegurarse de que la gente lo utilice para siempre».

Conclusión

Esta exploración de la infraestructura de IA generativa solo toca la superficie, y los rápidos avances en el desarrollo tecnológico y la inversión en los componentes fundamentales subyacentes son notables. La adquisición de empresas como MosaicML por cantidades asombrosas y el creciente número de jugadores en el campo demuestran el inmenso valor y el interés en este espacio.

Es un panorama complejo y en constante evolución con múltiples capas, desde modelos básicos hasta ajustes, desde semiconductores hasta alojamiento en la nube y marcos de aplicaciones hasta supervisión de modelos. Cada capa desempeña un papel crucial a la hora de aprovechar el poder de la IA generativa y permitir sus aplicaciones en diversas industrias. Y en esta investigación, muchas empresas que comienzan en un área se expanden a otras.

Si desea profundizar en estos temas o conversar, no dude en enviarme un mensaje directo de LinkedIn o un correo electrónico.